实时语法检查模型预计每年运行超过5000亿次查询

实时语法检查模型预计每年运行超过5000亿次查询。

有人说好文章都是编辑出来的。幸运的是,为了满足全球读者的挑剔要求,微软正在为数百万人提供AI语法编辑器。

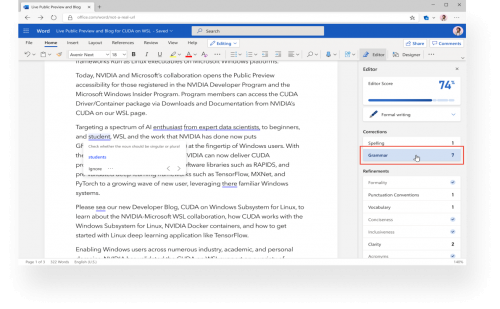

该工具如同一名优秀的编辑一样快速而专业。这是由于微软编辑器在Microsoft Word在线版中对语法进行了改进,可以运用NVIDIA Triton 推理服务器、ONNX 运行时和Azure AI中的微软Azure 机器学习,来提供这种丰富的智能体验。

10月5日,NVIDIA首席执行官黄仁勋在GTC大会上的主题演讲中宣布了这一新讯。

日常工作中的AI应用

微软为Microsoft Office生产力应用用户提供强大的AI性能。这些节省时间的新功能包括实时语法建议、文档内问题解答(如 “完全匹配”之外的Bing文档搜索),以及帮助将句子填写完整的文本预测。

唯有通过深度学习和神经网络,才能实现这些提高生产力的功能。例如,与基于传统规则型逻辑构建的服务不同,在纠正语法方面,Word在线编辑器可以理解句子的上下文,并提供适当的单词选择建议。

这些深度学习模型可能涉及数亿个参数,它们必须具有可扩展性,并提供实现最佳用户体验所需的实时推理。预计仅用于语法检查的微软编辑器AI模型每年就要对Word在线处理超过5000亿次查询。

但这种规模的部署可能会大幅增加深度学习的预算。幸运的是,可通过Azure机器学习访问的NVIDIA Triton的动态批处理和并发模型执行功能将成本降低了约70%,并且在单个NVIDIA V100 Tensor Core GPU上实现了每秒450次查询的吞吐量,响应时间在200毫秒以内。

Azure机器学习具备管理模型生命周期所需的规模和能力,比如版本管理和监控。

在Azure 机器学习上通过Triton实现高性能推理

随着机器学习模型规模的不断扩大,模型训练和部署过程对GPU的需求比以往任何时候都更加迫切。为了将AI部署到生产中,企业机构正在寻找可扩展的推理服务解决方案、对多个框架后端的支持、最佳的GPU和CPU利用率以及机器学习生命周期管理。

Azure 机器学习中的NVIDIA Triton和ONNX 运行时堆栈提供可扩展的高性能推理。Azure机器学习用户可以利用Triton对多种框架的支持、实时、批和流推理、动态批处理以及并发执行等性能。

借助AI进行Word创作

作家和诗人Robert Graves曾说过:“没有写得好的文章,只有改得好的文章。”换言之,就是要对写好的文章进行编辑和润色。

您可以使用Word在线编辑器同时进行这两项工作。尽管编辑器是Word中第一个通过Triton和ONNX 运行时增加速度与广度的功能,但它仅仅是更多功能的开始。

想要了解更多有关AI计算的最新技术,解锁GPU前沿应用,可点击链接:https://www.nvidia.cn/gtc/keynote/,观看GTC 2020秋季站主题演讲上的精彩内容。

申请创业报道,分享创业好点子。点击此处,共同探讨创业新机遇!