引言语音合成(Text-to-Speech, TTS)是指文字转语音相关技术。随着人工智能技术的发展,TTS 的声学模型和声码器模型效果都在不断提高,单一语言在数据量足够的情况下已经可以合成较高品质的语音。研究人员们也逐渐开始关注跨语言语音合成领域,本文介绍网易游戏广州 AI Lab 在 Interspeech 2022 中发表的一篇跨语言语音合成论文《Exploring Timbre Disentanglement in Non-Autoregressive Cross-Lingual Text-to-Speech》,该论文提出了音素长度调节模块来解决 IPA 序列与单语言对齐系统对齐结果的不匹配问题,同时使用了基于 Fastpitch 的非自回归声学模型,实验结果表明了训练集说话人数量的增加、音高和能量的显示建模(主要是音高)都有助于非自回归跨语言 TTS 中说话人音色和语言的信息解耦。

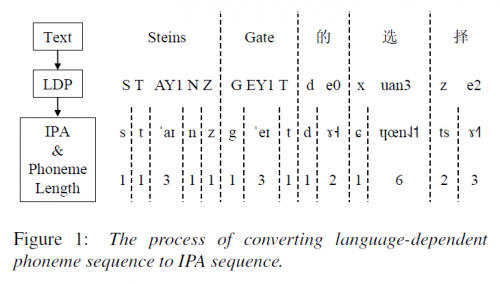

论文标题:Exploring Timbre Disentanglement in Non-Autoregressive Cross-Lingual Text-to-Speech论文链接:https://arxiv.org/abs/2110.07192演示网址:https://hyzhan.github.io/NAC-TTS/论文相关背景目前跨语言TTS的主要实现方法有:跨语言中间特征、跨语言文本表示、对抗式训练、发音单元设计、跨语言文本处理模型等。更多相关背景知识及发展概述可阅读:《跨语言语音合成方法的发展趋势与方向》,本文不再赘述。近年来,FastSpeech、FastPitch、FastSpeech2 等非自回归声学模型除了在语音生成速度上表现出巨大优势,生成语音自然程度也越来越高,相关论文作者试图在跨语言语音合成系统中使用非自回归声学模型,但是由于典型的非自回归声学模型需要加入显式的音素发音时长进行模型训练,这会导致模型增加使用 IPA 这类跨语言文本表示的难度(因为这样会需要有一个跨语言的文本语音对齐系统)。该论文提出了音素长度调节模块来避免这个问题,同时还在 FastPitch 的基础上加入了 energy predictor,评估了训练数据集说话人数量、不同模块及文本表示、是否使用对抗训练对说话人音色解耦的影响。方法概述首先基于开源字典 [1]构造一个自定义的字典,将语言相关的音素转换(LDP)为 IPA 表示,其中语言相关的音素集在中文中为拼音,在英文中为 Aprabet 表示,将 IPA 音素序列及其对应 LDP 的音素长度输入到上图的 Phoneme Length Regulator,即可实现输入表示序列与单语言对齐系统得到的发音时长相匹配,进而完成声学模型的训练。以下图中的 “Steins Gate 的选择”为例,“Steins Gate” 对应的 Aprabet 表示为:S T AY1 N Z,“的选择”对应的拼音为:d e0 x uan3 z e2;根据前面构造的自定义字典将语言相关的音素(LDP)转换为对应的 IPA 字符及其 IPA 字符数量;通过 embedding 的方式将 IPA 字符映射成对应的 IPA embedding 序列,并基于 LDP 对应的 IPA 字符数量对 IPA embedding 序列进行聚合得到,LDP 级别的 embedding 序列。各个序列的长度约束关系见参考论文 2.2 节,总的来说就是用变长的 phoneme length 来控制需要聚合的 IPA embedding 序列数量,以此来表示对应的 LDP embedding,从而让 IPA 序列可以使用单语言对齐的音素时长信息,完成整个模型的训练。

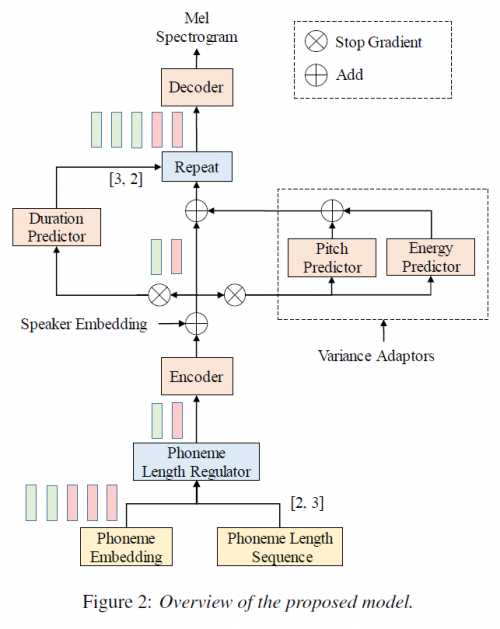

声学模型框架上是基于 Fastpitch 的声学模型加入了 energy predictor 模块,再结合了论文提出的 Phoneme Length Regulator 模块。还有一个区别就是论文的 speaker embedding 是加在 encoder output 的,而不是常见的 encoder input,以及在预测 variance predictor 的时候对输入进行了 detach 操作来避免时长、音高、能量预测对 encoder 的潜在影响。

实验

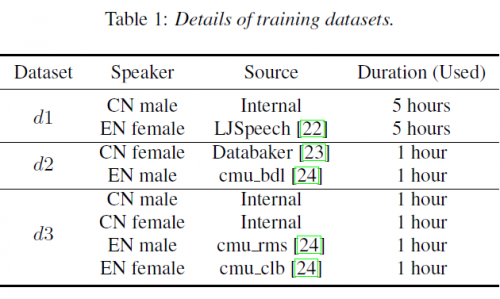

论文实验主要涉及中文和英文,中文数据集为开源的标贝女声及内部数据集,英文数据集为开源的 LJSpeech 及 CMU arctic 数据集。作者构造了三种性别平衡及语言平衡的数据集进行实验,表 1 描述了各个子数据集的构成情况:d1:中文男声 5 小时,英文女声 5 小时;d2:中文女声 1 小时,英文男声 1 小时;d3:中文男女声各 1 小时,英文男女声各 1 小时,通过逐步增加训练集规模来进行相关实验,评测阶段仅使用 d1 中的 LJSpeech 的英文女声及内部数据集的中文男声进行评测。4.1 说话人数量的影响

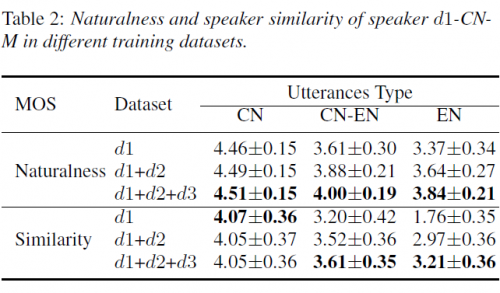

论文首先研究了训练集中包含不同数量的说话人时,说话人和语言信息之间的纠缠情况。其中 d1 有 2 个说话人,d1+d2 有 4 个说话人,d1+d2+d3 有 8 个说话人,均为性别及语言平衡的数据集。表 2 评估了 d1 数据集中文男声在纯中文、纯英文和中英混合句子的语音自然程度及相似度。可以发现,d1 训练集中,中文男声在中文语音上表现最好,中英混合语音表现次之,纯英文表现最差,尤其是纯英文的相似度指标上。这意味着训练集中一种语言只有一个说话人,对提升目标说话人的跨语言发音能力帮助有限;同时作者也推测虽然 IPA 符号可以用在所有语言上,但是依旧存在某种语音有一些独有的 IPA 符号的情况,从而在这种一种语言只有一个说话人的训练集上导致了说话人音色信息和语言信息的混淆。另一方面,随着训练集两种语言说话人数量的增加,在跨语言语音场景下,中文男声说话人的 Naturalness 及 Similarity 主观评分均出现了较明显的提高,Naturalness 主观评分的方差也逐渐在减小。这说明了训练集中说话人的多样性不仅有利于说话人音色信息和语言信息的解耦,还有利于提高非自回归跨语言 TTS 模型的稳定性。因此,后续实验均基于 d1+d2+d3 的数据集进行。4.2 对比实验

论文选择了 3 个对比模型,一个是基于 IPA 表示 Tacotron 声学模型框架的 Tacotron-based,二是基于 LDP 表示和 GRL(gradient reversal layer)Fastspeech 声学模型框架的 FastSpeech-LDP,三是将 FastSpeech-LDP 中的 LDP 表示替换为本文中的 IPA 表示加 Phoneme Length Regulator 模块的方法,最后则是本文提出的模型框架。总的来说,在本实验中几个非自回归模型的表基本都好于 Tacotron-based;对比 FastSpeech-LDP 和 FastSpeech-IPA 中英说话人在三种类型文本的Naturalness和Similarity指标,两者的 Naturalness 基本接近,不过 FastSpeech-IPA 在大部分情况取得了更高的 Similarity 主观评分,这表明 IPA 表示加上 Phoneme Length Regulator 模块的实现可以帮助模型学习不同语言的发音。然而,本文提出的模型在跨语言场景的表现明显优于 FastSpeech-LDP 及 FastSpeech-IPA,这说明使用 variance adaptors 有助于提高跨语言语音合成模型的性能表现,虽然 variance adaptors 本身是作为解决语音合成中的“一对多”问题提出的,但是实验表明了对语音的韵律特征进行显示建模有助于说话人和语言信息的解耦。4.3 消融实验

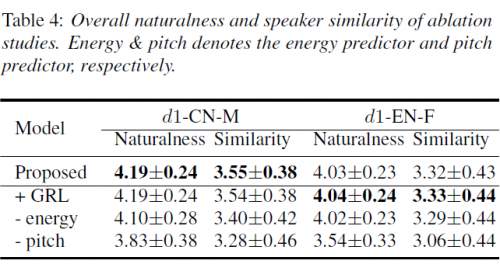

论文 做了三组消融实验来评估 GRL 梯度反传层、pitch predictor、energy predictor 对 proposed model 的影响。实验表明,GRL 的引入并没有带来收益,一方面可能是 IPA 表示加上说话人多样性的引入已经能较好地对说话人音色信息和语言信息进行解耦,另一方面可能是因为 GRL 中的超参数较为敏感,暂不适用于本文提出的模型。去掉 pitch predictor 和 energy predictor 导致了语音自然程度和相似度有较明显的恶化(尤其是 pitch predictor),这表明了在 variance predictor 的有效性。总结论文提出了 Phoneme Length Regulator 模块,使得非自回归跨语言 TTS 模型中的 IPA 表示与单语言强制对齐信息可以同时使用;构造了一个不需要对抗式训练、基于 IPA 表示的 Fastpitch-based 模型,取得了不错的语音自然程度及说话人相似度。论文实验表明说话人多样性、IPA 表示、variance adaptors 都能够帮助非自回归跨语言 TTS 模型解耦说话人和语言信息。本文通过引入一个较为简单的方法使其可以利用单语言强制对齐信息和 IPA 表示,再加上说话人多样性和 variance adaptors 引入,已经可以在不使用常见对抗式训练的方式在跨语言语句上取得不错的语音自然程度及说话人相似度。另外,第一版论文和演示网页还展示了对中式英文发音可控性的潜力,如果有 PLR 模块的示例代码会更好一些,不过本身思想也不算复杂,实现难度不大,从实验结果来看,总体上是一个逻辑通顺、简单又有效的解决方案。(作者:音月)

申请创业报道,分享创业好点子。点击此处,共同探讨创业新机遇!