robots

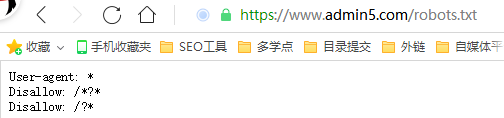

1、robots协议是什么robots协议也叫robots.txt(统一小写)是一种存放于网站根目录下的ASCII编码的文本文件,它通常告诉网络搜索引擎的漫游器(又称网络蜘蛛),此网站中的哪些内容是不应被搜索引擎的漫游器获取的,哪些是可以被漫游器获取的。2、robots协议怎么写因为一些系统中的URL是大小写敏感的,所以robots.txt的文件名应统一为小写。User-agent:*Disall

与“robots”的相关热搜词:

-

- robots协议怎么写 作用是什么?

- 1、robots协议是什么robots协议也叫robots.txt(统一小写)是一种存放于网站根目录下的ASCII编码的文本文件,它通常告诉网络搜索引擎的漫游器(又称网络蜘蛛),此网站中的哪些内容是不应被搜索引擎的漫游器获取的,哪些是可以被漫游器获取的。2、robots协议怎么写因为一些系统中的UR

2021-03-03 14:29 -

- robots具体应该禁止些什么文件

- 网上robots的写法,说法一大堆,也不知谁对谁错,到底robots该禁止那些文件呢?今天大概总结一下:首先说明一点:每天百度派出的蜘蛛是有限的,robots写出来是为了节省蜘蛛资源让蜘蛛能更快的进行有效爬取和收录!针对企业站来说,本身蜘蛛资源不会很多,所以我们更要珍惜蜘蛛的每次爬取,让其都有意义,

-

- robots文件编写秘籍 新手必看

- 当我们的网站上线之后,一定会有一些不想让百度抓取的页面、文件,针对这种问题,我们就要使用协议去屏蔽。那么这个协议是什么?究竟怎么写这个协议呢?一、什么是搜索引擎协议:搜索引擎协议也就是我们常说的robots.txt。这是我们网站和搜索引擎之间的协议。当搜索引擎来到我们网站的时候,会先看一看有没有这个

-

- robots.txt文件怎么写才正确呢?

- 曾庆平SEO在前面的文章中讲过robots.txt概念的时候,留下一个问题:为什么曾庆平SEO的robots.txt写得那么复杂?曾庆平SEO的robots.txt:http://www.***seo.com/robots.txt这样做的目的是,让搜索引擎看来网站更规范和权威。1、用robots.t

2020-11-24 11:09 -

- 百度站长平台检测robots.txt 提示301错误代码 怎么解决

- 今天我们来讲解一个小问题,很多朋友更新了robots.txt文件以后,然后去百度站长平台监测robots.txt是否正确,却被提示:百度暂时无法链接服务器,错误301代码,这个时候我们应该怎么解决那?其实解决方法并不是很难,今天就教大家排查这个问题。1,服务器是否可以正常访问!我们最先检查的应该是我

-

- 网站robots文件没做好带来的影响不可小视

- 网站优化过程非常容易忽视的一个就是robots文件,因为如果网站彻底不做robots文件好像也没有多大影响,但不做好这个文件,引起的问题可不能小视。什么是robots文件?简单的说就是告诉搜索引擎哪些是你能抓取的哪些是你不能碰的,哪个蜘蛛可以进来哪个不能进来,做好了robots文件有以下几点好处:节

-

- 你不知道的robots文件那些事

- robots.txt文件,是每一个搜索引擎蜘蛛到你的网站之后要寻找和访问的第一个文件,robots.txt是你对搜索引擎制定的一个如何索引你的网站的规则。通过该文件,搜索引擎就可以知道在你的网站中哪些文件是可以被索引的,哪些文件是被拒绝索引的。我们就可以很方便地控制搜索引擎索引网站内容了。在很多网站

-

- 看完秒懂robots.txt写法和注意事项

- robots.txt直接放在网站根目录下,是蜘蛛访问网站时,第一个抓取的文件。robots.txt是告诉蜘蛛网站的哪些文件允许抓取,哪些文件不允许抓取,甚至可以指定特定的蜘蛛能不能抓取特定的文件。没有抓取就没有收录,没有收录就没有排名。所以作为第一蜘蛛访问的文件,写好robots.txt是很重要的,

2019-01-07 11:46 -

- 解除网站Robots封禁全过程

- robots协议或者说robots文件对搜索引擎优化中非常重要,但设置出错可能会导致收录下降或不能正常收录。今天,小小课堂SEO自学网带来的是《【robots文件协议】解除Robots封禁全过程》。希望本次的百度SEO优化培训对大家有所帮助。一、robots被封禁的问题来源小小课堂SEO自学网为Wo

2018-11-14 21:11 -

- robots文件是否支持中文目录?

- 一个关于robots的问题:我们有个站点的目录结构使用的是中文,这样式儿的:www.a.com/冒险岛/123.html,那在制作robots文件和sitemap文件的时候,可以直接使用中文吗?百度能获取到吗?在实际操作中我们发现,sitemap中有文件是可以生效的,但robots封禁貌似没有反应,

-

- 网站上线前把robots写了所有蜘蛛禁止抓取,取消后还是这样怎么办

- 不知道有没有其他站长跟我一样,技术部把网站后台搭建好了,然后网站还是很多东西需要修改的,特别是TDK改了一遍又一遍,但是这时候我没有去百度站长申请闭站保护,却是在网站根目录上传了robots文件,里面写着:User-agent:*Disallow:/这表示我的网站禁止所有蜘蛛来抓取,那么这种情况有什

-

- 浦东新区法院:百度地图抓取信息未违反Robots协议

- 5月26日,大众点评起诉百度不正当竞争案的一审结果落槌。上海市浦东新区法院判定百度公司的搜索引擎抓取信息未违反Robots协议。百度方代理律师称,百度地图的信息抓取行为具有合法性、正当性,严格遵守了国际通行的行业网站抓取惯例,即Robots协议。Robots协议也称为爬虫协议、机器人协议等,全称是“

2016-05-27 15:02 -

- 网站误封Robots该如何处理

- robots文件是搜索生态中很重要的一个环节,同时也是一个很细节的环节。很多站长同学在网站运营过程中,很容易忽视robots文件的存在,进行错误覆盖或者全部封禁robots,造成不必要损失!那么如果误操作封禁了robots怎么办?今天我们请到了厦门258网站运营负责人——郑军伟,为我们分享网站rob

2016-02-18 15:42